انعقد مؤتمر للأساتذة والمطورين والمهندسين المتخصصين في إنشاء وتطوير تقنيات الذكاء الاصطناعي (AI) في كاليفورنيا في الفترة من 5 إلى 8 يناير. خلال أربعة أيام من المناقشات النشطة، تم تجميع قائمة بمبادئ الذكاء الاصطناعي المستخدمة بالفعل الآن والتي ينبغي استخدامها في المستقبل. وفي الحقيقة تم تلخيص ما حققته البشرية في مجال التعلم الآلي خلال العقود الماضية.

بشكل عام، لا يرتبط "الذكاء الاصطناعي" بشكل مباشر بالدماغ البشري والذكاء في حد ذاته. هكذا يفسر عالم الكمبيوتر الأمريكي جون مكارثي، مؤلف هذا المصطلح، هذا المفهوم: "المشكلة هي أننا لا نستطيع بعد أن نحدد بشكل عام ما هي الإجراءات الحسابية التي نريد أن نطلق عليها اسم "فكرية". نحن نفهم فقط بعض آليات الذكاء. ولذلك فإن الذكاء في حدود هذا العلم لا يعني إلا العنصر الحسابي للقدرة على تحقيق الأهداف في العالم. تم الإعلان عن ذلك في عام 1956 في مؤتمر عقد في جامعة دارتموث.

وأكد الوقت كلمات مكارثي. اليوم، نستخدم أدوات المعلومات لتحقيق أهدافنا، وأفكارنا حول تبسيط العالم أو التفكير في المستقبل ترتبط ارتباطًا وثيقًا بالرمز البرمجي. نعم، لقد غيرنا فكرة الأعمال نفسها، لكننا لم نستبعد تماما وجودها في كل مكان.

لذلك، تم تقسيم جميع "قوانين المستقبل" الـ 23 المجمعة إلى ثلاث مجموعات: الأسئلة العلمية والبحثية، والأخلاق والقيم، والمنظورات التكنولوجية.

دستور الذكاء الاصطناعي

شريحة البحوث

- الغرض من أبحاث الذكاء الاصطناعي ليس فقط إنشاء جهاز ضيق التركيز، بل فائدة للمجتمع بأكمله.

2. يجب أن تذهب الاستثمارات في الذكاء الاصطناعي إلى مجال البحث لضمان فائدة التكنولوجيا، مما يسمح بإعطاء إجابات أكثر دقة وتعميمًا على الأسئلة الناشئة في علوم الكمبيوتر والاقتصاد والقانون والأخلاق والعلوم الاجتماعية:

- كيف يمكن ضمان الموثوقية العالية للذكاء الاصطناعي، ومقاومة اختراقات القراصنة بنجاح ومنع الأعطال الناشئة بسهولة؟

- كيف يمكننا، بمساعدة الأتمتة، الوصول إلى الهدف الضروري بإنفاق أقل قدر من الموارد؟

- كيف يمكن تجديد النظام القانوني بكفاءة وضمان العدالة وفقًا للقانون الحديث ومراعاة ظهور الذكاء الاصطناعي؟

- ما هو الوضع القانوني والعرقي الذي سيحصل عليه الذكاء الاصطناعي؟

3. ضمان التفاعل البناء والمتساوي بين الباحثين والسياسيين.

4. تم تحقيق الانفتاح والشفافية الكاملة لثقافة الاستخدام الإضافي للذكاء الاصطناعي.

5. التفاعل والتعاون بين الباحثين في مجال الذكاء الاصطناعي لتجنب المنافسة الحادة.

قيم اخلاقية

6. يجب أن تكون أنظمة الذكاء الاصطناعي آمنة وموثوقة طوال فترة التشغيل بأكملها.

7. أقصى قدر من التوضيح السريع لأسباب المشاكل والقضاء عليها.

8. يجب معاقبة أي تدخل للنظام المستقل في قرارات المحكمة وإخضاعه للإبلاغ في حالة التحقق من قبل عضو مختص في اللجنة (شخص).

9. تقع المسؤولية عن الضرر الناتج والخلق المتعمد لموقف خطير بسبب خطأ في التصميم أو البرنامج على عاتق المطورين والمهندسين.

10. يجب أن تسعى جميع أنظمة الذكاء الاصطناعي المستقلة إلى معرفة القيم العالمية.

11. يجب تصميم الذكاء الاصطناعي وتشغيله بطريقة تتوافق مع المثل العليا للكرامة الإنسانية والحقوق والحريات والتنوع الثقافي.

12. يجب أن تكون المعلومات التي نشأت في عملية استخدام الذكاء الاصطناعي من قبل شخص ما متاحة في المستقبل لنفس الشخص (إمكانية التصرف في النتائج والبيانات المجمعة).

13. يجب ألا يحد الذكاء الاصطناعي، عند التعامل مع البيانات الشخصية، بشكل غير معقول من الحريات الحقيقية أو الخيالية للأشخاص.

14. يجب أن تستفيد تقنيات الذكاء الاصطناعي وأن تكون في متناول أكبر عدد ممكن من الناس.

15. من المسلم به أن الإنجازات الاقتصادية والاجتماعية التي حققها الذكاء الاصطناعي سلمية ويجب توجيهها لصالح البشرية.

16. لدى الشخص دائمًا خيار: اتخاذ القرار بنفسه أو تكليف الذكاء الاصطناعي بذلك.

17. هدف الذكاء الاصطناعي هو تحسين وإثراء المجتمع دون التسبب في الدمار والكوارث.

18. يجب تقليل احتمالية استخدام تكنولوجيا الذكاء الاصطناعي في سباق التسلح إلى الصفر، بل يجب أن ينتهي التنافس المسلح أيضًا.

أسئلة طويلة الأمد

19. يجب علينا أن نقيم برصانة تامة حدود قدرات الذكاء الاصطناعي من أجل تجنب الإنفاق غير العقلاني للموارد.

20. سيكون تطوير الذكاء الاصطناعي مكثفًا، لذا يجب أن تكون التكنولوجيا تحت السيطرة حتى لا تسبب ردود فعل لا رجعة فيها.

21. يجب التخطيط للمخاطر، وخاصة المخاطر الواسعة النطاق، بطريقة تضمن تقليل الأضرار المحتملة إلى أدنى حد.

22. أنظمة الذكاء الاصطناعي قادرة على التطوير الذاتي والتكاثر الذاتي، مما قد يتسبب في تدهور جودة نشاط الذكاء الاصطناعي، لذلك ينبغي إجراء مراقبة منتظمة للمؤشرات الرئيسية.

23. الذكاء الخارق هو التكنولوجيا التي تخدم وسوف تخدم لصالح البشرية جمعاء، ولا تخضع لأي منظمة خاصة أو دولة محددة.

اقرأ أيضا: Hyperloop: ماذا عن سباقات القطارات الفراغية؟

دعونا نستعرض الأطروحات الرئيسية للتقرير. يشعر المتخصصون بالقلق من تخلفهم في وقت التطوير المكثف للذكاء الاصطناعي، لذلك يسعون جاهدين لضمان السيطرة المطلقة على التكنولوجيا. كما يتم التأكيد مرارًا وتكرارًا على القيمة العامة العالمية للذكاء الاصطناعي وارتباطه بالثقافة الإنسانية. ومع ذلك، سنكتشف قريبًا ما إذا كان سيتم تنفيذ هذه الخطة. الذكاء الاصطناعي يشبه الجرو، فهو الآن يركض ويمرح، لكن نوع الكلب الذي سيكون عليه في النهاية يعتمد في المقام الأول على أصحابه.

في الوقت الحالي، هذا "مشروع القانون" في مرحلة الموافقة من قبل مواطني دولة الأرض، لذلك إذا كنت تريد مستقبلًا آمنًا وسعيدًا وتكنولوجيًا، فلا تتردد "تصويت" لتبني هذه المبادئ المعقولة والضرورية تمامًا.

اختبار تورينج

كان عالم الرياضيات العظيم آلان تورينج منخرطًا أيضًا في تكنولوجيا الذكاء الاصطناعي، لذلك توصل إلى اختبار مثير للاهتمام للغاية. تم تقديم اختبار تورينج لأول مرة في مقالة بعنوان "آلات الحوسبة والعقل" في المنشور الفلسفي "العقل" في عام 1950. فكرة الاختبار هي تحديد قدرات التفكير الآلي، وبشكل عام، وجوده على هذا النحو.

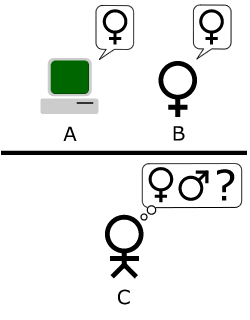

التفسير القياسي هو كما يلي: "يتفاعل الشخص مع جهاز كمبيوتر واحد وشخص واحد. وبناء على إجابات الأسئلة يجب عليه أن يحدد مع من يتحدث: مع شخص أو مع برنامج كمبيوتر. ومهمة برنامج الكمبيوتر هي تضليل الشخص وإجباره على اتخاذ القرار الخاطئ." لا يرى جميع المشاركين بعضهم البعض، ويتم التواصل في شكل اختبار، حيث أن الغرض من الاختبار ليس اختبار القدرات التقنية لجهاز التعرف على الأشياء، بل القدرة على تقليد العقل البشري.

وتتم المراسلات أيضًا على فترات زمنية محددة، بحيث لا يتمكن "القاضي" من التوصل إلى نتيجة بناءً على سرعة الردود. ومن المثير للاهتمام أن هذه القاعدة تم اختراعها نظرًا لحقيقة أنه في وقت إنشاء هذا الاختبار، كانت أجهزة الكمبيوتر تتفاعل بشكل أبطأ من تفاعل الشخص، والآن أصبح الأمر ضروريًا أيضًا، لأن الشخص الآن يلعب دور المتخلف.

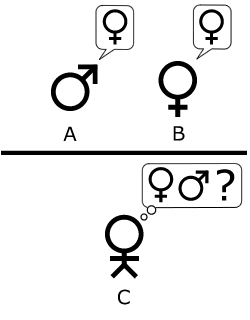

وعلى أساس هذا الاختبار أيضًا، تم إنشاء اختبار مماثل لتحديد جنس المحاورين. في دور القاضي، يجب على اللاعب C التواصل مع اللاعبين A وB، وهما في الواقع رجل وامرأة.

في إحدى الأوراق البحثية حول الذكاء الاصطناعي، تم التعليق التالي: "الآن نتساءل: ماذا سيحدث إذا لعبت الآلة دور اللاعب "أ" في هذه اللعبة؟" هل سيتخذ مقدم العرض قرارات خاطئة عندما تُلعب اللعبة بطريقة كما لو كان رجل وامرأة يشاركان في الاختبار؟ هذه الأسئلة ستحل محل سؤالنا الأصلي: "هل تستطيع الآلات التفكير؟"

وهذا يعني أنه بدلاً من سؤال واحد بعيد المنال تمامًا، سنجيب على الأسئلة الأسهل ونقوم بذلك بالتتابع، وبالتالي نقترب أكثر فأكثر من الإجابة التي طال انتظارها على السؤال الرئيسي حول قدرات التفكير في الذكاء الاصطناعي.

المصدر: مستقبل الحياة, ويكيبيديا وأكثر قليلا ويكيبيديا